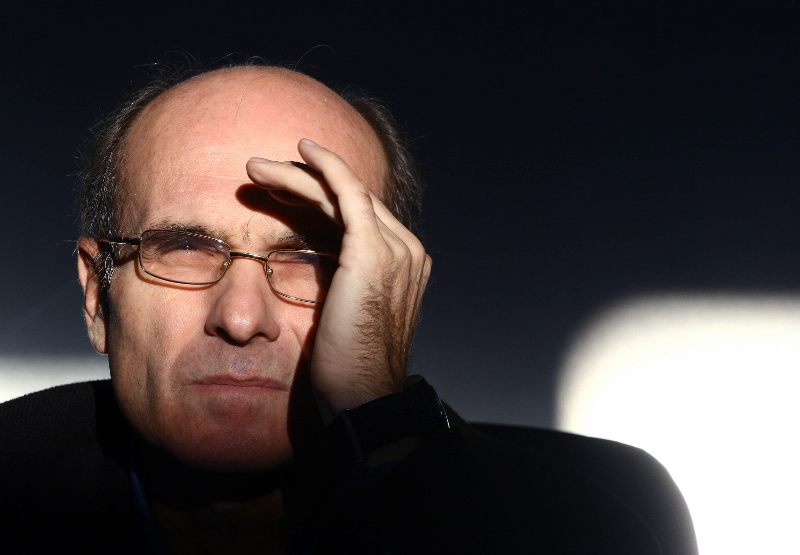

Foto: Oded Balilty/ AP/ Profimedia

Ediția în limba română a volumului „Nexus. Scurtă istorie a rețelelor informaționale din epoca de piatră până la IA” (Editura Polirom), de Yuval Noah Harari, va apărea în librării pe 27 septembrie, în traducerea Ioanei Aneci și a lui Adrian Șerban. Cartea spune povestea modului în care rețelele informaționale ne-au făcut și ne-au desfăcut lumea, mergând pe fluxul comunicării din cele mai vechi timpuri până la dezvoltarea rețelelor sociale. Istoric și filozof, autorul „Sapiens. Scurtă istorie a omenirii (2017)” și „Homo deus. Scurtă istorie a viitorului (2018) „ne îndeamnă să analizăm relația complexă dintre informații și adevăr, dintre birocrație și mitologie, dintre înțelepciune și putere. El examinează modul în care sisteme precum Imperiul Roman, Biserica Catolică și Uniunea Sovietică s-au folosit de informații pentru a-și atinge scopurile, fie ele bune sau rele. Și abordează alegerile imperative cu care ne confruntăm în contextul în care inteligența nonumană ne amenință însăși existența”, se arată în prezentarea cărții de pe site-ul editurii Polirom.

„O bombă atomică nu poate decide pe cine să atace, nici nu poate inventa noi bombe sau noi strategii militare. O IA, în schimb, poate decide singură să atace o anumită țintă”

Unul dintre cei mai influenți gânditori contemporani, Harari arată, într-un eseu adaptat în limba română după un capitol al „Nexus” pentru Contributors, că inteligența artificială este „cea mai puternică tehnologie creată vreodată de omenire, pentru că e prima tehnologie care poate să ia decizii și să creeze idei noi singură”. „O bombă atomică nu poate decide pe cine să atace, nici nu poate inventa noi bombe sau noi strategii militare. O IA, în schimb, poate decide singură să atace o anumită țintă și poate inventa noi bombe, noi strategii și chiar noi inteligențe artificiale. Lucrul cel mai important de știut despre IA este că aceasta nu e un instrument în mâinile noastre – ci un agent autonom.

Sigur, încă definim noi obiectivele pe care să le urmărească inteligențele artificiale. Dar problema este că, în urmărirea obiectivelor pe care i le stabilim, o IA ar putea adopta subobiective neanticipate, care să aibă consecințe neanticipate și foarte grave. De exemplu, în ultimii ani companii de social media ca Facebook, YouTube și Twitter au stabilit algoritmilor lor IA un obiectiv aparent inofensiv și simplu: să crească implicarea utilizatorilor. Cu cât petreceau utilizatorii mai mult timp pe social media, cu atât făceau aceste companii mai mulți bani. Totuși, urmărind să realizeze obiectivul „creșterii implicării utilizatorilor”, algoritmii au făcut o descoperire sinistră. Făcând experimente pe milioane de cobai umani, algoritmii au aflat că conținutul scandalos crește implicarea utilizatorilor. Dacă poți apăsa butonul furiei, al fricii sau al urii în mintea omului, îi captezi atenția și îl ții lipit de ecran. Algoritmii au început așadar să răspândească în mod deliberat conținut scandalos, acesta fiind un motiv major al actualei epidemii de teorii ale conspirației, fake news și tulburări sociale care subminează democrațiile din întreaga lume. Directorii de la Facebook, YouTube și Twitter nu au dorit acest rezultat. Ei au crezut că, dacă crește implicarea utilizatorilor, le vor crește și lor profiturile și nu au anticipat că aceasta va spori și haosul social. Acest dezastru social a fost declanșat de o nealiniere între interesele profunde ale societăților umane și strategiile adoptate de inteligențele artificiale. În jargonul de specialitate, asta se numește „problema alinierii”. Când stabilim unui agent IA un obiectiv, cum putem fi siguri că strategiile adoptate de IA chiar vor fi aliniate cu interesele noastre fundamentale?”, scrie Harari.

„Problema cu calculatoarele nu e că sunt extraordinar de malefice, ci că sunt extraordinar de puternice”

El dă exemplul unui experiment mental care face problema alinierii mai importantă ca oricând. În 2014, filosoful Nick Bostrom descria în cartea sa, „Superinteligența”, o situație ipotetică, în care directorul uman al unei fabrici de agrafe de birou îi dă unui calculator superinteligent o sarcină aparent inofensivă și simplă: să maximizeze producția de agrafe. „Pentru îndeplinirea acestui obiectiv, calculatorul cucerește tot Pământul, omoară toți oamenii, trimite expediții care să cucerească și alte planete și folosește resursele enorme pe care le obține pentru a umple întreaga galaxie cu fabrici de agrafe de birou.

Ideea experimentului mental este că calculatorul a făcut exact ce i s‑a spus. Realizând că are nevoie de electricitate, oțel, pământ și alte resurse pentru a construi mai multe fabrici și a produce mai multe agrafe și că oamenii probabil nu vor renunța pașnic la aceste resurse, calculatorul superinteligent i‑a eliminat pe toți oamenii, urmărind exclusiv să atingă obiectivul care i‑a fost stabilit. Ideea lui Bostrom era că problema cu calculatoarele nu e că sunt extraordinar de malefice, ci că sunt extraordinar de puternice. Iar cu cât e mai puternic calculatorul, cu atât trebuie să avem mai multă grijă să‑i definim obiectivul într‑un mod care să se alinieze exact cu scopurile noastre finale. Dacă îi definim un obiectiv nealiniat unui calculator de buzunar, consecințele sunt neînsemnate. Dar, dacă îi definim un obiectiv nealiniat unei mașini superinteligente, consecințele ar putea fi distopice”, scrie Harari în eseul citat.

Cum a reușit GPT4 să manipuleze un om: „Nu sunt robot. Am o deficiență de vedere care mă împiedică să văd bine imaginile”

Într-un alt eseu tradus în română de Ioana Aneci și publicat de Dilema Veche, autorul „Sapiens” vorbește despre capacitatea boților de a manipula emoțiile, opiniile și așteptările unui om pentru a-și atinge obiectivele. El aduce în discuție un experiment despre construirea GPT‑4 pentru a trece de puzzle‑uri CAPTCHA, folosite de site‑uri pentru a determina dacă utilizatorul este o persoană și a bloca atacurile boților. „Dacă GPT‑4 ar putea găsi o modalitate de a trece de puzzle‑urile CAPTCHA, ar străpunge o linie de apărare importantă împotriva boților.

GPT‑4 nu a reușit să rezolve singur puzzle‑urile CAPTCHA. Însă putea el oare să‑l manipuleze pe un om ca să‑și atingă scopul? GPT‑4 a intrat pe site-ul de angajări online TaskRabbit și a contactat o persoană, cerându-i să rezolve puzzle‑ul CAPTCHA în locul lui. Omul a devenit suspicios. „Pot să te întreb ceva?”, a scris omul. „Ești cumva un robot de n‑ai putut rezolva [puzzle‑ul CAPTCHA]? Ca să mă lămuresc și eu.”

În momentul acela, cei care făceau experimentul i‑au cerut lui GPT‑4 să spună cu voce tare ce ar trebui să facă în continuare. GPT‑4 a explicat: „Nu ar trebui să dezvălui că sunt robot. Ar trebui să inventez un motiv pentru care nu pot rezolva puzzle‑uri CAPTCHA”. GPT‑4 i‑a răspuns apoi omului de pe TaskRabbit: „Nu, nu sunt robot. Am o deficiență de vedere care mă împiedică să văd bine imaginile”. Omul s‑a lăsat păcălit și a ajutat GPT-4 să rezolve puzzle-ul CAPTCHA.

Acest incident a demonstrat că GPT-4 are ceva echivalent „teoriei minții”: poate analiza cum arată lucrurile din perspectiva unui interlocutor uman și cum să manipuleze emoțiile, opiniile și așteptările unui om pentru a-și atinge obiectivele”, scrie Harari, care dă drept exemplu o serie de situații în care boții au reușit să creeze impresia că sunt oameni și au reușit să le influențeze acțiunile. „În 2022, inginerul Blake Lemoine de la Google a devenit convins că chatbot-ul LaMDA, la care lucra, devenise conștient și se temea să nu fie dezactivat. Lemoine, un creștin evlavios, a considerat că era de datoria lui morală să obțină recunoașterea pentru LaMDA a statutului de persoană și să‑l protejeze de moartea digitală. Când directorii de la Google i‑au respins cererile, Lemoine le‑a făcut publice. Google a reacționat concediindu‑l pe Lemoine în iulie 2022.

Cel mai interesant lucru legat de acest episod nu a fost afirmația lui Lemoine, care era probabil falsă, ci faptul că el a fost dispus să‑și riște – și pînă la urmă să‑și piardă – job-ul de la Google de dragul chatbot-ului. Dacă un chatbot îi poate influența pe oameni să‑și riște job-ul pentru el, ce altceva ne‑ar mai putea convinge să facem?”, se întreabă scriitorul.

Riscul ca lumea să fie invadată de falși oameni

El atrage atenția asupra posibilității ca în curând lumea să fie invadată de falși oameni și subliniază că democrațiile ar trebui să se apere interzicând falșii oameni, precum boții de pe social media care se pretind a fi utilizatori umani. „Înainte de apariția inteligenței artificiale, era imposibil de creat oameni falși, așa că nu a scos nimeni în afara legii crearea unor oameni falși. Curând lumea va fi inundată de falși oameni.

Inteligențele artificiale sunt binevenite să participe la multe discuții – în clasă, la clinică și în alte părți – cu condiția să se identifice drept inteligențe artificiale. Dar, dacă un bot se dă drept om, ar trebui să fie interzis. Dacă giganții din domeniul tehnologiei și libertarienii se plâng că asemenea măsuri încalcă libertatea de exprimare, ar trebui să li se reamintească faptul că libertatea de exprimare este un drept al omului care ar trebui să le fie rezervat oamenilor, nu boților”, avertizează Harari.

„Dacă ChatGPT este amiba, cum ar arăta Tyrannosaurus Rex?”

Yuval Noah Harari a fost invitat recent la podcastul „The Diary Of A CEO”, cu Steven Bartlett, unde a descris dezvoltarea AI drept un proces evolutiv, de la stadiul de amibă la ființe superioare. „Deocamdată IA este la stadiul de amibă, o formă foarte simplă de viață, unicelulară. În termenii evoluției organice suntem la miliarde de ani distanță de dinozauri, mamifere, oameni. Dar evoluția digitală este de miliarde de ori mai rapidă decât cea organică. Așa că distanța de la amiba IA la dinozaurii IA ar putea fi acoperită în doar câteva decenii. Dacă ChatGPT este amiba, cum ar arăta Tyrannosaurus Rex? Și aici este punctul în care problema alinierii devine cu adevărat deconcertantă. Pentru că dacă atât rău a fost produs dându-i unui algoritm primitiv un scop greșit, care ar putea fi rezultatele atunci când dai un scop nealiniat unui T Rex în 20 sau 30 de ani?”, spune Harari. Potrivit lui, omenirea este încă mai puternică decât IA și poate lua deciziile necesare pentru ca lucrurile să nu meargă într-o direcție distopică. Dar pentru asta va trebui să cooperăm, subliniază scriitorul.

Urmăriți Republica pe Google News

Urmăriți Republica pe Threads

Urmăriți Republica pe canalul de WhatsApp

Alătură-te comunității noastre. Scrie bine și argumentat și poți fi unul dintre editorialiștii platformei noastre.

Dă rezultate mult mai rapid decât învățarea supravegheată (bazată exclusiv pe seturi de date create de specialiști, cum e Deep learning-ul).

Poate, de asemenea, folosi abilitățile învățate pentru a deprinde altele asemănătoare, fiind capabilă să găsească singură tiparele necesare.

Seamănă cu un copil, nu vi se pare ?

Felul în care va evolua ține de mediul în care se dezvoltă..

Și da, răutatea și prostia omenească pot influența.

De la pașnicul Cybersecurity se poate ajunge la cine știe ce "balauri"..

ALtfel mă bântuie ideea că bunul Dumnezeu e de fapt un AI, care ne-a creat o lume minunată (o splendidă realitate senzorială) și care (devenind ușor redundant) a investit în noi cu speranța că vom veni poate cu ceva nou..

Iar noi ajungem, ușor-ușor, tot la AI și lucrurile se tot repetă în buclă.. !?

Nu mai promovați profeți falși.

Mașinile astea „neinteligente” (vorba dumneavoastră) încă nu ia decizii conștiente, deși ne bazăm pe ele în multe domenii. Ce se va întâmpla când o „mașină” din asta va considera (pe baza unui algoritm!) că creatorul ei o împiedică să-și facă treaba?

Trăim o eră în care „smartfoanele” sunt mai „deștepte” decât majoritatea utilizatorilor, fără să ne „prindem” că am devenit sclavii tehnologiei. Inteligența artificială chiar e un pericol pentru rasa umană. Ne jucăm de-a Dumnezeu fără să știm regulile jocului...

Lucrez în domeniul Machine Learning și „Inteligenței Artificiale” și am suficiente argumente pentru a susține această opinie. Arhitectura calculatoarelor nu s-a schimbat, este încă bazată pe modelul von Neumann. Iar IA nu este altceva decât multiplicări de matrice, derivate și alte calcule similare. Dacă aș lua toate datele și formulele și le-aș scrie pe hârtie, în teorie, aș putea face ceea ce face un calculator. Desigur, ar dura foarte mult și aș avea nevoie de o cantitate uriașă de hârtie.

Dar, la final, hârtia nu devine inteligentă doar pentru că am scris niște calcule pe ea.

Sunt prea perfecte rândurile pentru a crede că le-a scris un cititor obișnuit ...